Mašiny na hnev: Ako slepý hon na zapojenie formoval dnešné sociálne siete

Stvorili sme obludy, ktoré vnášajú do našej spoločnosti obrovský negatívny efekt. Už mnoho rokov ho neustále vidíme a cítime každý deň, pričom o jeho existencii nieto pochýb. Najsmutnejšie na celej situácii pritom je, že to vôbec nemusí takto byť. Sociálne siete môžu mať obrovský prospech a minimálne negatívne vedľajšie účinky. Všetci sa však len s hrôzou pozeráme na to, ako sa tieto mechanizmy vydali na celkom inú cestu.

Skúste sa vžiť do toho, že ste tvorili niečo, čo používajú miliardy ľudí na celom svete. Každý deň z toho majú radosť a osoh a ide o užitočnú súčasť ich života. Určite by vás to naplňovalo a cítili by ste, že takáto práca dáva vášmu životu zmysel. Háčikom by bolo, že v priebehu toho, ako svoje dielo neustále zlepšujete a zefektívňujete, si začnete všímať, že určité typy úprav menia celý svet k horšiemu.

Nešlo by pritom o vec názoru či pohľadu. Na vlastné oči by ste sledovali a exaktne merali, že zmeny, ktoré vkladáte a spúšťate, zhoršujú správanie stoviek miliónov ľudí, zhoršujú vašu krajinu, svet a celé ľudstvo.

Zrejme by ste okamžite premýšľali nad tým, ako by ste tento negatívny vplyv mohli odstrániť. Chceli by ste implementovať vhodnejšie riešenia, ktoré také škodlivé efekty nemajú. S hrôzou by ste ale zisťovali, že nemôžete. Váš zamestnávateľ by všetky navrhované opravy odmietol a označil ich za nevhodné. Znamenali by totiž, že by firma zarobila iba toľko miliárd dolárov, ako v minulom roku a nie viac.

Priamym efektom toho, že váš produkt je plný negatívnych vedľajších vplyvov je totiž to, že ľudia produkt používajú viac, dlhšie, vášnivejšie a s väčšou vervou. Z pohľadu zamestnávateľa je teda vhodné ponechať aktuálny stav a dokonca ho ešte viac zefektívňovať. To totiž preukázateľne prináša väčší zisk a zvyšuje silu a vplyv platformy. Firma rastie, a to jediné sa považuje za dôležité. Všetko ostatné je len bezcenný vedľajší efekt, nad ktorým neživá firemná entita nemá žiadnu zodpovednosť.

AKO PRICHÁDZA NA SVET TABAKOVÝ ALGORITMUS

Predchádzajúce riadky nie sú fikciou. Algoritmy Facebooku a iných veľkých sociálnych sietí, ktoré denne zasahujú do života niekoľkých miliárd ľudí, majú obrovskú moc. Aj relatívne malá zmena ich vlastností sa na takýchto objemových úrovniach prevteľuje do obrovského vplyvu na našu spoločnosť, pričom v mnohých ohľadoch môže ísť o vplyv mimoriadne negatívny a kontraproduktívny.

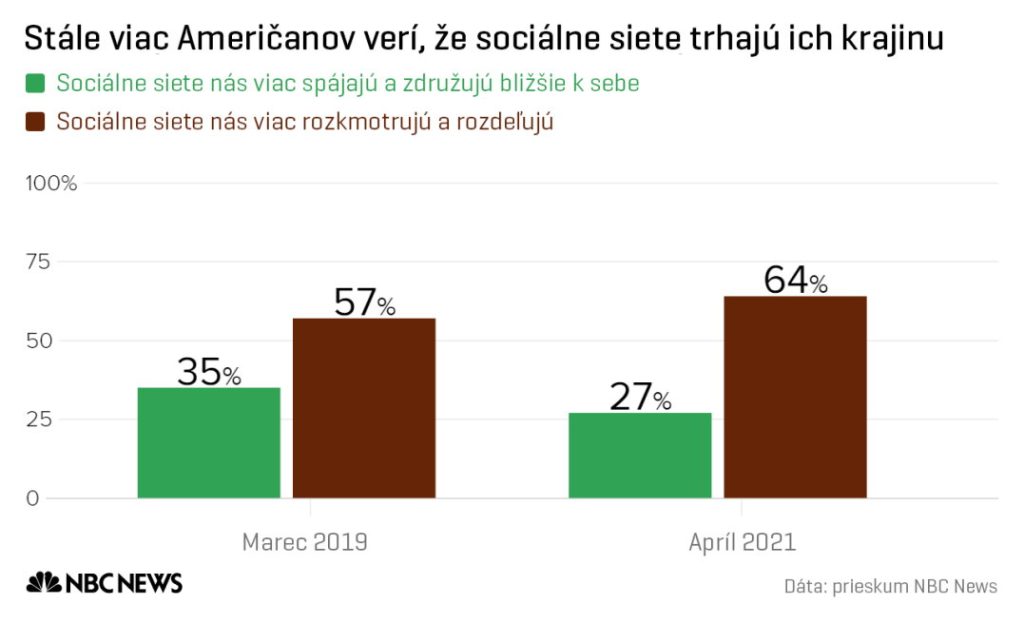

Tento vplyv môžeme cítiť a merať „naslepo“ externe, či už z hľadiska rôznych štúdií, prieskumov, alebo verejnej mienky a postojov. Omnoho presnejší prehľad však o ňom majú samotní tvorcovia daných algoritmov, ktorí ho vidia na vlastné oči a cielene alebo z donútenia manažmentu nad ním zatvárajú oči.

Nejde o predtuchy či dohady. Skutočný proces poznáme z prvej ruky, z priameho rozprávania vedúcich vývojárov a vrcholových manažérov, ktorí z Facebooku, Googlu či iných firiem na protest odišli a rozhodli sa poodhaliť pokrievku nad bublajúcim a nebezpečným kotlom návykovej zloby, ktorý pomáhali vytvoriť.

Budovanie súčasného podhubia a škodlivého prostredia sociálnych sietí malo pritom relatívne plynulý priebeh. Aj keď sa možno zdá, že situácia sa výrazne zhoršila v posledných rokoch, v skutočnosti sme v tomto období len začali naplno pociťovať efekt, ktorý sa postupne cielene konštruoval jeden a pol dekády.

Počiatky samotnej problematiky môžeme vidieť už v raných fázach budovania Facebooku, ktorých podobu nám pre pár mesiacmi poodhalil Tim Kendall, jeden z prvých vysokých manažérov tejto firmy, ktorý mal za úlohu vytvoriť efektívny obchodný model tejto sociálnej siete a transformovať ju do podoby enormne zarábajúcej platformy.

Jeho pohľad a výpovede sme mohli vidieť na konci minulého roku na pôde amerického kongresu, kde prebehlo vypočúvanie svedkov v súvislosti so stále prebiehajúcim vyšetrovaním, ktorého úlohou je odhaliť, akou veľkou mierou platformy sociálnych sietí prispievajú k zvyšovaniu extrémizmu a radikalizácie obyvateľov USA (prebieha pod názvom „Mainstreaming Extremism: Social Media’s Role in Radicalizing America“).

Tim Kendall vo Facebooku pracoval ako riaditeľ pre monetizáciu, v rokoch 2006 až 2010. V jeho období začal Facebook raketovo zvyšovať čistý zisk z miliónov na stovky miliónov dolárov ročne, pričom nastolený trend po jeho odchode pokračoval a postupne sa začal rátať na miliardy a následne na dnešné desiatky miliárd dolárov ročne.

Kendall si vo svojom svedectve nedával servítku pred ústa a predostrel jasný dôvod toho, prečo má súčasná podoba najväčšej sociálnej siete taký efekt. „Našou úlohou bolo vyťažiť čo najviac pozornosti používateľov, ako to len bolo ľudsky možné. Používali sme overené minulé spôsoby veľkých tabakových spoločností, v snahe vytvoriť náš produkt čo najviac návykový.“

Kendall vo svojej tabakovej analógii pritom pokračoval a kongresmanom predkladal jasnú paralelu s históriou:

„Tabakové spoločnosti začali zvyšovať svoj zisk tým, že postupne vkladali do svojich produktov čoraz silnejší nikotín. V priebehu času však prišli na to, že s pribúdajúcimi rokmi to už nezvyšuje predaje tak rýchlo ako predtým. V snahe udržať masívny rast svojich firiem začali do cigariet pridávať aj cukor a mentol, aby fajčiari mohli držať dym v pľúcach dlhšie a viac nikotín vstrebali. Vo Facebooku sme pridávali aktualizácie statusov, tagovanie fotiek a lajky, rovnako v snahe zvyšovať závislosť od nášho základného produktu. Budovali sme to tak, aby zdanlivý status a reputácia hrala na sieti kľúčovú rolu, čím sme položili základy súčasnej krízy mentálneho zdravia mládeže.“

Aj keď málokoho prekvapí, že firma sa bude snažiť od začiatku budovať svoj produkt tak, aby ho ľudia používali čo najviac, v tomto prípade ide predsa len o trochu inú situáciu. Úmyselné hľadanie prvkov, vyvolávajúcich čo najväčšiu závislosť sa stalo základným stavebným kameňom jej úspechu. Kendall to vo svojej výpovedi popisoval ako celkom kľúčový faktor:

„Tak ako tabakové firmy začali pridávať do produktov bronchodilatanciá (pozn. spôsobujú roztiahnutie priedušiek a zvýšenie priechodnosti dýchacích ciest), aby umožnili dymu pokryť väčší priestor, my sme vo Facebooku umožnili ľahké a rýchle šírenie dezinformácií, konšpiračných teórií a vyprefabrikovaných správ. Tento výbušný a nebezpečný obsah nám však nestačil. Chceli sme stále viac. Aby firma mohla neustále rásť na zisku, potrebovali sme stále viac ľudí a hlavne, stále viac času, ktorý na Facebooku trávia.“

Kendall vo svojom svedectve vysvetľoval, že práve to bola jediná finálna metrika, na ktorej Facebooku vo výsledku záležalo. Zapojenie používateľov totiž vedie k zisku a ich interakcia s obsahom, ktorý vidia, má teda prednosť pred všetkým ostatným. Aj keď jednotliví vývojári a takisto manažéri si rýchlo začali uvedomovať, že tento prístup bude viesť k negatívnym dôsledkom pre používateľov a s rastúcim vplyvom sociálnych sietí aj pre celú spoločnosť, zakrývali si pred tým oči.

„Pôvodne sme tento hon na väčšie zapojenie vnímali tak, že ním vlastne prispievame aj k dobru používateľov, takže je to v poriadku. Postupne sme si však začali uvedomovať, že zvyšovanie zapojenia nad všetko ostatné znamená, že používatelia budú vtiahnutí do špirály závislosti a nebudú môcť využívať svoj čas pre svoj najlepší prospech. Že bude pre nich problém opustiť našu platformu. Boli to nevyhnutné reálne dôsledky našich prístupov, ale nedávali sme im význam. Hon na čoraz väčšie zapojenie vždy vyhral. Bol pre nás vždy najprednejší.“

Kendall poukázal na to, že v čase úvodného prudkého rastu firmy, kedy v nej pôsobil, neexistovala žiadna iniciatíva systematicky potlačiť nebezpečný alebo toxický obsah. Práve naopak, šírenie tohto obsahu vo veľkom bolo na osoh a čo bolo na osoh bolo vždy z pohľadu firmy žiadané a cielene zosilňované.

Sociálna sieť tak mohla kvitnúť do súčasnej podoby a pretvárať a formovať spoločnosť do novej podoby sveta. Z jeho pohľadu bol smer, ktorým sa Facebook vydal, prirodzeným dôsledkom biznisu. Firmám totiž ide o zisk, nie o dobro spoločnosti a pokiaľ nebudú v danej oblasti prítomné dostatočne efektívne a silné vládne regulácie, trh nie je schopný sa sám kontrolovať.

Kendall jasne prezentoval, že vedúci predstavitelia firiem budú vždy nevyhnutne odvracať zrak od negatívnych dôsledkov a budú vnímať len finančnú stránku veci. Kongresmanov pritom upozornil, že pokiaľ nebudeme za takéto správanie aplikovať veľké trestné postihy, alebo citeľné finančné pokuty, prístup firiem sa nikdy nezmení:

„Ak firmy nebudeme trestať za škodu, ktorú na ľudskej spoločnosti spôsobujú, budú sa len opakovane ospravedlňovať v tlačových správach za svoje predošlé chyby a budú donekonečna prázdno sľubovať nápravu do budúcnosti.“

Dôvod je podľa neho jasný. Zachovať súčasný stav je skrátka príliš lukratívne.

AKO SA ZRODILA UMELÁ INTELIGENCIA NA ZLOSŤ A NENÁVISŤ

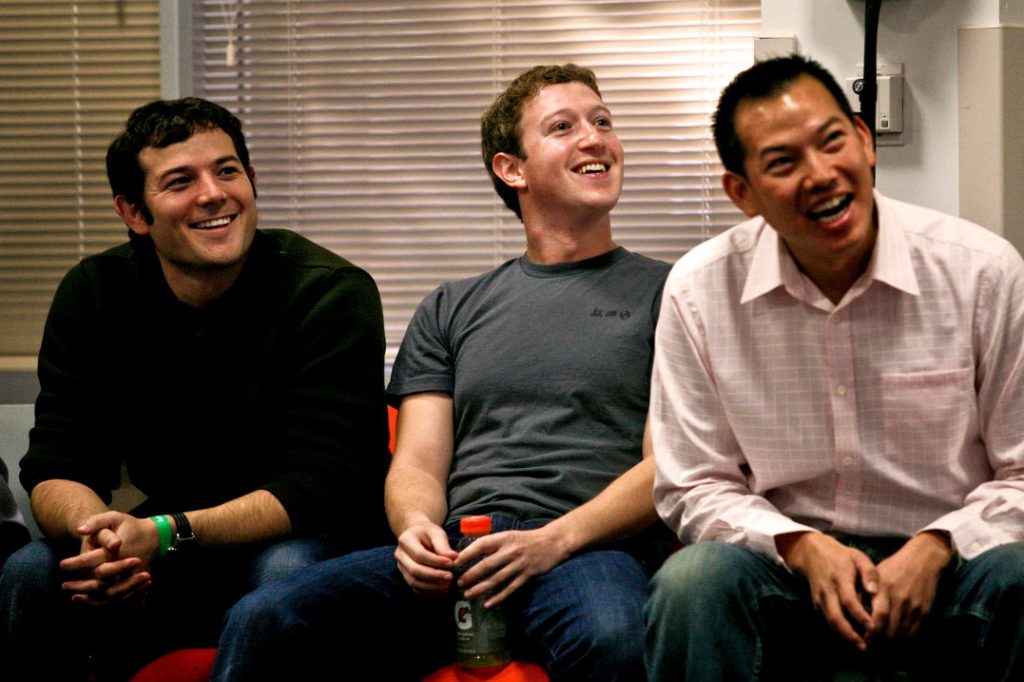

Je dôležité si uvedomiť, že osoby stojace za škodlivými algoritmami Facebooku nie sú nejaké komiksové stelesnenia „záporákov“, ktorí sa smejú popod fúzy a mydlia si ruky, pretože chcú robiť zlé veci. Nejde ani o to, že by samotný Mark Zuckerberg túžil pomocou svojej siete manipulovať ľudí, polarizovať a donútiť ich, aby verili najrôznejším hlúpostiam, či iba tomu, čo si on sám želá.

Tieto negatíva boli vždy dôsledkom, nie prvotným cieľom, pričom postupom času sa z nich stal dopravný prostriedok, ktorý k cieľu viedol. Kým na konci prvej dekády tohto storočia stáli v popredí základné dizajnové rozhodnutia návrhárov a snaha vytvoriť jednotlivé prvky tak, aby bola pre ľudí platforma čo možno najnávykovejšia, v priebehu druhej dekády vošiel do akcie nový a extrémne silný princíp, ktorý poslal všetko do celkom nových rovín.

Do hry vstúpila umelá inteligencia, v podobe základných prvkov strojového učenia a následne pokročilých hlbokých neurónových sietí, s pomocou ktorých sa začal algoritmus na zapojenie cibriť a upravovať v krátkych časových intervaloch do nevídanej efektivity.

Veľká implementácia týchto riešení začala vo Facebooku v roku 2012, pričom jednou z kľúčových osôb, ktorá sa podpísala na efektivite a vplyve algoritmov a ich súčasnej podobe bol Joaquin Quiñonero Candela. Skúsený vývojár systémov umelej inteligencie, ktorý pôvodne viedol vývojový tím britskej pobočky laboratória Microsoft Research, kde sa so svojím tímom zaoberal algoritmami na zvýšenie efektivity reklamných prvkov vyhľadávača Bing.

Jeden z priateľov ho v tom čase pozval na návštevu Facebooku, stále ešte relatívne mladej a rapídne rastúcej firmy. V tej dobe ešte systémy umelej inteligencie mali ďaleko k masívnemu rozšíreniu a použitiu, ako ho vidíme dnes. Len málo významných technologických firiem do nich investovalo veľké peniaze, s plánom používať ich vo veľkom meradle, pričom Facebook nebol výnimkou.

Candela sa však v jednom zo svojich rozhovorov pre MIT Technology Review vyjadril, že jedným z hlavných popudov, ktorý ho do Facebooku prilákal bolo, že pri návšteve videl, ako jediný inžinier vykonal počas svojho pracovného dňa obrovskú funkčnú zmenu sociálnej siete, bez nejakého schvaľovacieho procesu.

V Microsofte bol zvyknutý na to, že veľké zmeny v algoritmoch a vyhľadávači prechádzali zdĺhavým kontrolným procesom, formálnym dohľadom a hodnotením. Šlo o stelesnenie motta Marka Zuckerberga „Hýb sa rýchlo a rozbíjaj veci“, ktoré vo Facebooku bolo neustále prítomné. Candela počas nasledujúceho týždňa absolvoval všetky náležitosti a do firmy nastúpil.

Jeho úloha bola sprvu podobná ako v Microsofte. Vylepšoval účinnosť reklám, s pomocou trénovaných systémov strojového učenia. Aj relatívne rudimentárny algoritmus umelej inteligencie si dokáže všimnúť, že niektoré druhy reklám sú u určitých skupín používateľov úspešnejšie a zareaguje na to tak, aby z daného efektu vyťažil čo najviac.

Typicky môže napríklad odpozorovať, že ženy majú výrazne väčšiu pravdepodobnosť na interakciu s reklamami na oblečenie ako muži, a následne vyprodukuje model, ktorý tieto typy reklám zobrazuje ženám viac a dosahuje tak vyššiu efektivitu konverzie.

To, čo dostal Quiñonero Candela k dispozícii vo Facebooku, bolo dovtedy celkom nevídané. Náhle sa už systémy umelej inteligencie nemuseli trénovať na hrubých zdrojoch, ako bolo pohlavie či približný vek. Sociálna sieť mala k dispozícii obrovské množstvo detailných dát o tom, aké dané osoby boli a takisto ako s obsahom interagovali v poslednom čase.

V tejto dobe Facebook prekročil hranicu jednej miliardy používateľov a množstvo detailných osobných dát, ktoré vlastnil, nemalo v histórii obdobu. Žiadny človek by ich nedokázal spracovať a analyzovať svojpomocne v rozumnom čase. Avšak automatické samoučiace sa systémy, ktoré sa nikdy nenasýtia a neunavia, to dokázali. Počas krátkej doby začali reklamné mechanizmy obohatené o nové účinné algoritmy dosahovať výrazne väčšie úspechy. Facebook začal uhrýzať stále väčšie a väčšie sústa z reklamného koláča, ktorému dominoval Google.

To si začal všímať nielen manažment, ale aj ostatní inžinieri, pracujúci na klasických prvkoch sociálnej siete. Vytvorené mechanizmy umelej inteligencie (UI), ktoré sa uplatňovali pri reklamách, totiž bolo možné trénovať aj na iných dátach. Tak ako algoritmus mohol predpovedať, s akou pravdepodobnosťou používateľ bude interagovať s reklamou, tak mohol predpovedať s akou pravdepodobnosťou „lajkne“ príspevok, zareaguje komentárom na fotografiu, alebo ako dlho ešte bude posúvať tablu s obsahom, než odíde.

Počas roku 2013 začal Candela a jeho tím rapídne zvyšovať produkciu nových modelov, na rozdielne dáta a použitia. Kým na začiatku trvalo vybudovať, vytrénovať a otestovať nový model UI až šesť týždňov, nové riešenia a zrýchlené postupy to umožnili už za jeden. Programátori ich pritom okamžite používali a aplikovali do behu sociálnej siete. Úspech sa dostavil rýchlo.

Systémy UI si bleskovo začali všímať, aké príspevky mali najväčšiu pravdepodobnosť impulzívneho zdieľania, čím im umelo pridávali väčšiu dôležitosť a efekt rozširovania ešte znásobili. Typicky, ak napr. nejaké dva príspevky mali len priemerný počet zdieľaní, zatiaľ čo iný tretí nadpriemerný, algoritmus potlačil prominenciu tých dvoch menej úspešných, na úkor toho úspešnejšieho, čím jeho efekt ešte viac zosilnel.

Na ilustráciu si predstavte, že prvý príspevok získa počas prvých desiatich minút 10 zdieľaní, druhý takisto 10 a tretí 100. Namiesto toho aby sa všetky tri príspevky šírili ďalej sociálnou sieťou rovnakým tempom a počas dňa nabrali 10 000 + 10 000 videní u prvých dvoch a 100 000 u toho tretieho, algoritmus mohol ten tretí pretlačiť do popredia a dotiahnuť ho napríklad na milión prezretí, na úkor toho, že prvé dva príspevky zostali napríklad len na stovke.

Očividným dôsledkom bolo, že podoba informácie na platforme sa začala meniť. Systém UI neposudzoval, o aký príspevok šlo. Či bol vhodný, dôležitý alebo hodnotný. Dôležitá bola len metrika jeho úspechu z hľadiska prezretia, zdieľania a interakcie. A keďže ľudia s určitým obsahom interagujú vášnivejšie ako s iným, obzvlášť tým, ktorý viac pôsobí na základné emócie, jeho hodnota a prominencia v rámci siete a v očiach používateľov stúpala.

Veľkosť úspechu, s akým nové algoritmy UI zvyšovali efektivitu tably s príspevkami a interakciu používateľov, upútali pozornosť Zuckerberga a ďalšieho vrcholového manažmentu. Firma sa v tej dobe pripravovala na vstup na burzu, teda na ponúkanie predaja svojich akcií pre investičnú verejnosť (IPO). Postarať sa neprestajný a rýchly rast firmy, aj keď sieť mala už viac ako 1 miliardu používateľov, bolo prioritou. Kľúč bol jasný.

Zabezpečiť trvalú maximalizáciu pozornosti, ktorú je možné priamo transformovať na marketing a následne peniaze. Platformu teda musí používať stále viac ľudí, čoraz aktívnejšie a vášnivejšie. Musia na nej tráviť čoraz viac času. A základným prostriedkom, ktorý to mal umožniť, boli stále lepšie a lepšie systémy umelej inteligencie, trénované na čoraz väčšom množstve dát.

Počas nasledujúcich dvoch rokov Facebook investície do rozvoja UI masívne zvýšil. Na prelome rokov 2013 a 2014 vo firme vznikli dve veľké a dobre financované skupiny vývojárov UI, ktorých práca sa stala základným kameňom toho, ako sú funkcie a správanie sociálnej siete dnes riešené.

Prvý tím bol nazvaný FAIR (Facebook AI Research), a mal za úlohu napredovať vo všeobecnom vedeckom výskume princípov UI a podporovať progres v tomto smere ako celku. Po niekoľkých mesiacoch presviedčania sa do jeho čela postavil Yann LeCun, profesor Newyorskej univerzity a veľké meno na poli vývoja systémov strojového učenia, strojového videnia, robotiky a výpočtovej neurovedy.

Druhý tím, označený skratkou FAIAR (Facebook AI Applied Research), dostal za úlohu efektívne a rýchlo aplikovať aktuálne poznatky z odboru a implementovať ich efektívne do praxe, a teda fungovania sociálnej siete. Zaujímavou fonetickou hračkou je, že zatiaľ čo skratka prvého tímu je slovom pre „férovosť či spravodlivosť“, skratka toto druhého pri hovorom vyslovení znie ako „fire“, teda oheň. Hlavou tohto oddelenia sa stal práve Quiñonero Candela, pričom význam jeho práce začal v nasledujúcich rokoch ešte viac narastať. Modely vytvárané umelou inteligenciu začali dominovať rozhodovaniu o tom, čo ľudia na platforme sociálnej siete vidia.

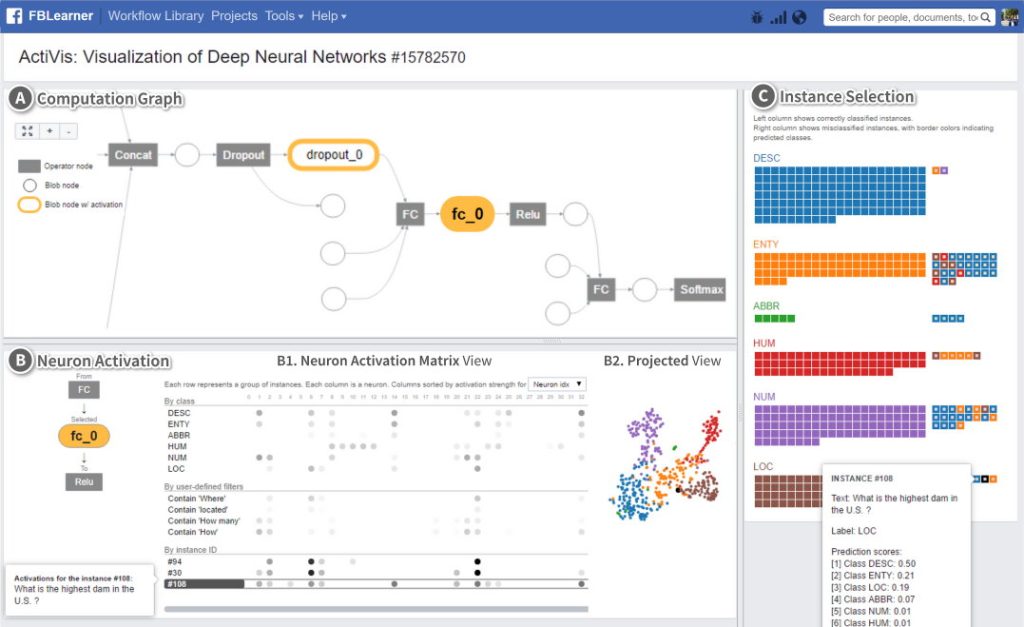

Hlavným prvkom tohto tímu sa stal tzv. FBLearner Flow, čo sa dá preložiť ako učiaci prúd/tok. Ide o platformu na rýchle vyvíjanie modelov UI, ktorú Candela so svojím tímom navrhli tak, aby v rámci nej mohol hocaký programátor Facebooku, bez akýchkoľvek znalostí tvorby systémov UI, vytrénovať vlastný algoritmus na základe ľubovoľných dát. Tento princíp sa stal taký úspešný, že počas dvoch rokov ho pravidelne začala používať až štvrtina programátorov Facebooku pri svojej bežnej práci.

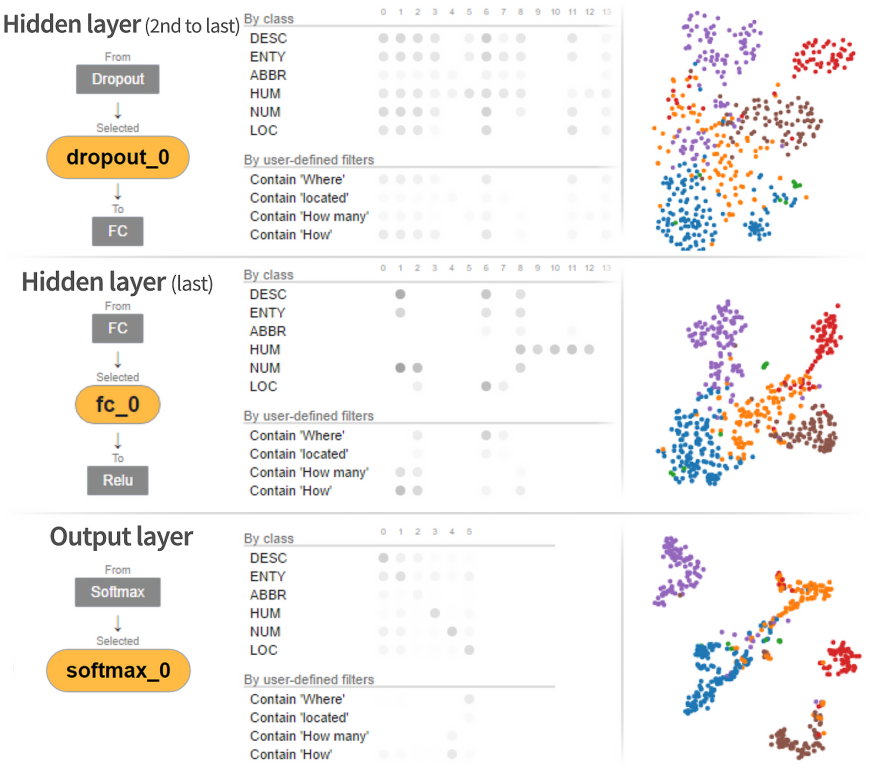

Systémy umelej inteligencie sa stali základným kameňom toho, ako interakcia používateľov a získavanie ich pozornosti prebiehala, pričom v roku 2016 už bolo vytrénovaných viac ako milión unikátnych modelov. Systémy UI sa už nejakým spôsobom používali takmer na všetko. Nielen na zoraďovanie príspevkov a ich uprednostňovanie a šírenie, ale aj v súvislosti s moderovaním, kategorizovaním, či v rámci hlbokých neurónových sietí aj s rozpoznávaním tvárí a určovaním toho, čo je na fotografiách.

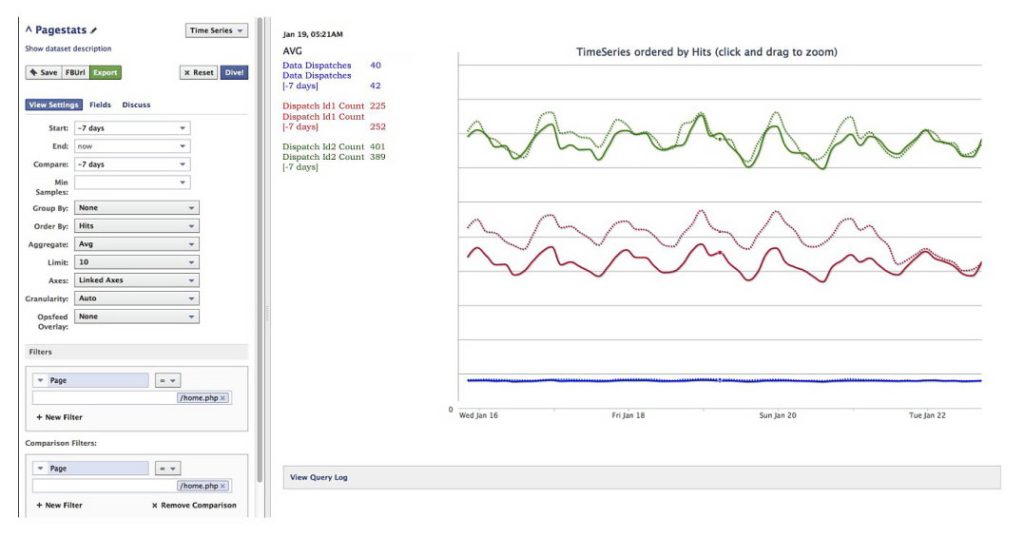

Neustále nové a nové modely UI sa stali pre Facebook alfou a omegou. Proces všednej reality firmy nám pekne poodhalil Krishna Gade, ktorý v rokoch 2016 až 2018 pracoval vo Facebooku ako technický a vývojový manažér pre tablu správ. Konkrétny vývojársky tím v rámci svojej každodennej práce skrátka programuje a trénuje cez FBLearner Flow nový model, ktorého úlohou je napr. meniť na základe nových dát poradie a viditeľnosť príspevkov na hlavnej stránke používateľa. Následne sa rýchlo otestuje na malom počte, napr. tisíckach používateľov (bez ich vedomia), pričom sa niekoľko hodín až dní meria, ako sa ich interakcia so sieťou zmení.

Ak nový model prinesie väčšie množstvo komentárov, „lajkov“, zdieľaní či príspevkov, alebo zvýši čas ktorý používatelia na sieti strávia, ide do ostrej akcie pre všetkých. Ak nejaký model naopak interakciu a zapojenie používateľov citeľne zníži, je okamžite vyradený a zlikvidovaný. Je pritom jedno, že pre mnohých používateľov mohol byť daný algoritmus prospešný. Ak nedokázal vyprovokovať nejaké akcie a zvýšiť čas, ktorý používatelia strávili na sieti, z pohľadu Facebooku bol nevhodný.

Krishna Gade sa na svojom osobnom Twitter profile vyjadril, že daná prax neplatí len pre novozavádzané algoritmy a modely, ale aj pre tie už dlhodobo zavedené, ktoré sú neprestajne ostro monitorované. Programátori dostávajú každých pár dní upozornenia, že sieť v nejakej metrike v poslednej dobe poklesla, napríklad v počte „lajkov“ či inej, pričom okamžite pátrajú po tom, ktorý model je príčinou, a potom nasleduje jeho nové natrénovanie alebo náhrada.

Vývojárom a takisto manažmentu Facebooku bolo dlhodobo jasné, že tento prístup má v sebe problémy. Modely, ktoré dosahujú najväčšiu maximalizáciu zapojenia prirodzene favorizujú extrémizmus, falošné bombastické správy a vo všeobecnosti akúkoľvek kontroverziu, či príspevky vyvolávajúce hnev. Hnev je nesmierne ostrá emócia, ktorá ľahko vyvolá spontánnu akciu.

Obsah ktorý vzbudí radosť, pokoj a dobrú náladu nikdy nedonúti ľudí k toľkým akciám a zapojeniu, ako obsah ktorý ich enormne nahnevá a rozohní, či trápi. Mechanizmy pritom výrazne vplývali nielen na americkú, ale aj celosvetovú spoločnosť. Uzatvárali ľudí do bublín, ktoré neprestajne pumpovali ich hnev a prispievali k náhlemu veľkému polarizovaniu spoločnosti, ktorého rýchle zvýšenie bolo v rokoch 2015 až 2018 enormne badateľné najmä na americkej politickej scéne.

Škandalózne odhalenia v súvislosti s firmou Cambridge Analytica, dômyselné zneužívanie týchto systémov na napádanie demokratických princípov a cielené rozsievanie svárov s ruským štátnym zapojením, viedlo v tomto období k tomu, že nad sociálnymi sieťami sa začali sťahovať prvé, skutočne výrazné mračná kritiky. Nielen od žurnalistov, ale aj politikov a bežnej verejnosti, ktorá si začala čoraz viac uvedomovať, že princíp fungovania populárnych sociálnych sietí nemá len benefity, pričom negatíva ktoré prinášajú nie sú vonkoncom malé a nepodstatné.

Pod vplyvom tohto tlaku vytvoril Chris Cone, produktový riaditeľ Facebooku, v roku 2017 vo firme novú pracovnú skupinu, ktorej úlohou bolo zistiť, ako veľmi Facebook prispieva k politickej polarizácii americkej spoločnosti a či ide o ozajstný efekt, alebo len dôsledok všeobecných zmien krajiny, ktoré Facebook len odzrkadľuje. Zistením bolo, že existuje jasná korelácia medzi modelmi Facebooku a negatívnymi javmi spoločnosti, vrátane zvýšenia polarizácie. Firme však bolo okamžite jasné, že potlačenie týchto vplyvov by výrazne znížilo zapojenie a mnohé iné metriky, súvisiace s aktivitami používateľov a ich závislosťou na platforme.

K týmto interným dokumentom sa v minulom roku dostali redaktori Wall Street Journal, pričom poukázali na to, že v polovici roku 2018 špeciálna pracovná skupina navrhla manažmentu Facebooku niekoľko potenciálnych riešení, avšak upozornila, že drvivá väčšina z nich je v nesúlade s firemnou politikou neustáleho rastu. Prakticky všetky riešenia tak boli manažmentom zavrhnuté a skupina bola následne rozpustená.

Všetko pokračovalo aj v nasledujúcich rokoch. Jeden z bývalých vývojárov UI Facebooku, ktorý začal vo firme pracovať po roku 2018, sa pre redakciu MIT Technology Review vyjadril, že jeho tím na prianie manažmentu opakovane vykonával nové a nové štúdie v tomto smere. Aj keď sa na problém snažili nazerať z rôznych uhlov, vždy dochádzali k rovnakému základnému záveru. Modely umelej inteligencie, ktoré najviac maximalizujú zapojenie a akcie používateľov, prirodzene zvyšujú polarizáciu spoločnosti.

Na dátach jasne videli a veľmi presne merali, ako používatelia z rôznych skupín súhlasili či nesúhlasili s konkrétnymi ideami, s ktorých obsahom v poslednej dobe interagovali a hlavne, ako sa v nasledujúcich mesiacoch ich správanie zmenilo. Narastal hnev a nenávisť, pričom nech bol dôvod a obsah, ktorý za to mohol akýkoľvek, model umelej inteligencie sa vždy naučil, že najlepším riešením na zvýšenie aktivity a zapojenia používateľa je kŕmiť ho týmto obsahom čoraz viac a smerovať ho pomocou podsúvaného obsahu k čoraz extrémistickejším názorom. Preferovať umiernenosť, rozumnosť a balans informácií bolo kontraproduktívne.

Takéto modely boli zavrhované pre svoju neefektívnosť vo zvyšovaní zapojenia. Vývojár, ktorý pri svojom marcovom rozhovore požiadal redaktorov, aby jeho meno nezverejnili, v obave o svoju budúcu zamestnateľnosť, priamo popísal, že on aj jeho kolegovia neustále videli a jasne merali, ako sa ľudia v priebehu času pôsobením zavedených algoritmov stále viac a viac polarizovali. Museli to však ignorovať.

Najviac ho pritom zasiahlo to, keď boli odmietnuté aj návrhy jeho tímu na pomoc ľudom v depresii. Pri meraní negatívnych javov algoritmov totiž spolu s kolegami odmerali, že u ľudí, ktorí mali tendenciu prezerať čoraz melancholickejší obsah, čo býva jeden z možných znakov depresie, sa systém umelej inteligencie naučil naštartovať negatívnu špirálu, kde namiesto vedenia k „extrémizmu“ algoritmus ťažil pozornosť používateľa vedením k čoraz negatívnejšiemu obsahu, čo zvyšovalo riziko veľkého zhoršenia ich mentálneho stavu.

Vývojársky tím tak manažmentu navrhol, že aspoň pre tieto skupiny používateľov by sa tieto modely na maximálne zvýšenie zapojenia a aktivity vypli, alebo potlačili. Nestretlo sa to však s pochopením. Znižovanie zapojenia a zastavenie rastu aktivít bolo vždy zlé a nikto sa týmto smerom neodvážil vybrať, aj keď to bolo s jasne pozitívnym účelom (z hľadiska používateľa, nie však firmy). Postupne sa tak vývojári a manažéri, ktorí boli neprestajne hodnotení a finančne odmeňovaní na základe úspešnosti ich projektov podľa týchto metrík, naučili tieto nápady ignorovať.

OZAJSTNÉ A PREDSTIERANÉ SNAHY O NÁPRAVU

Facebook nikdy nebol jedinou technologickou firmou, ktorá na tieto problémy narážala. Podobne bol na tom aj Google so svojím YouTube, ktorého algoritmy umelej inteligencie začali byť v druhej dekáde tohto storočia čoraz viac používané v rámci odporúčacích mechanizmov, v snahe udržať divákov na portáli čo najviac a čo najdlhšie.

Pohľad z vývojárskej strany poznáme hlavne z rozprávania Guillaumeho Chaslota, ktorý sa na algoritmoch a ich vývoji podieľal, pričom poukázal na to, prečo sa v minulej dekáde z tohto dôvodu naštartoval obrovský boom aj tých najhlúpejších konšpiračných teórií (napr. o plochej Zemi). Podrobnejšie sme sa YouTube a jeho snahe o nápravu venovali v článku „Umelá inteligencia miluje závislosť a urobí všetko preto, aby vás do nej dostala“.

Aj keď vplyv YouTube a jeho negatív v dôsledku maximalizácie zapojenia bol nemalý (UI rýchlo prišla na to, ktorý obsah najviac „zahákuje“), situácia z pohľadu Facebooku bola predsa len iná. Dominancia tejto sociálnej siete je masívna a aktívne ju používa každý mesiac viac ako 2,8 miliardy ľudí.

Na rozdiel od videoportálu pritom obvykle kompletne zahlcuje všetky informačné kanály používateľov, vrátane videa, textu, spravodajských článkov a takisto sociálnej interakcie. Rast Facebooku v posledných rokoch vychádza hlavne z Ázie a Afriky (zatiaľ čo podiel v Európe a Severnej Amerike dlhodobo stagnuje z dôvodu už veľmi vysokej penetrácie), pričom nezriedkavo rozbublal existujúce kotle nepokoja v týchto oblastiach do hrôzostrašných dôsledkov.

Na konci roku 2018 vrchní predstavitelia Facebooku priznali, že princíp a funkcie ich sociálnej siete prispeli k rozohneniu a úspechu genocídnej protimoslimskej kampane v Mjanmarsku. Sociálna sieť niekoľko rokov pomáhala virálne šíriť vyprefabrikované správy a otvorené prejavy nenávisti používateľov proti Rohingom (indo-árijskej moslimskej etnickej skupine), čo na konci roku 2017 viedlo ku genocíde.

Etnické čistky stoviek dedín, pri ktorých bolo zabitých podľa odhadov OSN viac ako 10 000 žien, mužov a detí a 740 000 osôb bolo donútených utiecť cez hranice do susedných krajín, patria k hrôzostrašným kapitolám ľudstva. Podľa nezávislej medzinárodnej vyšetrovacej komisie OSN zohral Facebook rozhodujúcu rolu v celej eskalácii.

Po niekoľkých mesiacoch snahy, pri ktorej sa Facebook snažil zbaviť akejkoľvek asociácie a zodpovednosti napokon v novembri 2018 vydal na svojej stránke oficiálne vyhlásenie, v ktorom priznal určitú zodpovednosť za to, že „neurobil dosť pre to, aby zastavil využívanie jeho platformy na rozdúchavanie rozkolov a podnecovanie off-line násilia“.

Negatívne spravodajstvo a všeobecne negatívne asociácie viedli v nasledujúcich rokoch Facebook k razantnejším snahám. V minulom roku napríklad firma výrazne zasahovala proti šíreniu obsahu s popieraním holokaustu, protiočkovacím skupinám a takisto bláznivému konšpiračnému hnutiu QAnon. Problémom bolo, že všetky tieto snahy boli manuálne a konkrétne cielené, z dôvodu ich škodlivosti.

Nijako neriešili situáciu algoritmov a systémov umelej inteligencie, ktoré obsah tohto kalibru prirodzene slepo uprednostňovali na základe nútených metrík zapojenia a aktivít. Akonáhle sa teda objavili akékoľvek iné snahy nového druhu, algoritmicky boli okamžite efektívne zosilnené na maximum. Ako vhodný príklad môže slúžiť minuloročná situácia vo Veľkej Británii a Holandsku, kde konšpiračné hnutia prešli k fyzickým útokom a k podpaľovaniu telekomunikačného vybavenia piatej generácie, z dôvodu, že sa nazdávali, že tieto vysielače šírili koronavírus.

Algoritmy, ktoré boli tak precízne budované celú dekádu, boli trénované hlavne len na to, aby ľudom podstrkovali obsah, s ktorým budú štatisticky interagovať najviac a donútil ich k zotrvaniu na platforme. A to bol veľmi často ten, ktorý ich rozohnil, rozhneval, či v nich prebudil to najhoršie. Kým jednotliví programátori a vývojári okamžite videli problém, manažment firmy si skrátka zakrýval oči a prípadné snahy o nápravu smerovali celkom inde, k celkom nesúvisiacim záležitostiam.

Jednou z nich bola veľká snaha predpovedať to, či sa nejakí používatelia budú v blízkej dobe snažiť cez Facebook naživo streamovať svoju samovraždu, čo sa už žiaľ už niekoľko krát stalo. Idea manažmentu a vysokých predstaviteľov Facebooku bola, že by sa vytrénoval model UI, ktorý by analyzoval komentáre požívateľov tesne pred týmto činom, čo by umožnilo systému dopredu túto situáciu rozpoznať u iných ľudí. Videoprenos by tak mohol byť včas odstrihnutý a systém by takisto mohol upozorniť relevantné komunity na prevenciu samovrážd a zavolať dotyčnému pomoc.

Tento nápad bol u manažmentu veľmi populárny, pretože si nevyžadoval žiadne zmeny v zoraďovacích algoritmoch a mechanizmoch na zvyšovaní zapojenia. Nemal pre rast Facebooku žiadny efekt a tvoril len výbornú tému, ktorá sa dala podsunúť žurnalistom, ktorí mohli o Facebooku písať v pozitívnom svetle. Problémom bolo, že vývojový tím okamžite vedel, že niečo také nie je možné dosiahnuť.

Napríklad len z toho dôvodu, že tréningová vzorka je primalá. V rozhovore pre MIT Technology Review to jeden z vývojárov dokonca označil za „PR divadlo“, pretože snažiť sa napríklad na základe analýzy prvých 10 sekúnd videa strojovo odhadnúť, či sa človek v nasledujúcich 30 sekundách zabije, bolo absolútne nereálne.

Nápravy skutočných riešiteľných problémov, sú dlhodobo na Facebooku utláčané do pozadia. Ako príklad môže slúžiť report Wall Street Journal, ktorý vniesol svetlo do toho, že Facebook nielenže hosťuje veľké množstvo extrémistických skupín, ale hlavne ich algoritmicky vehementne propaguje používateľom, čo výrazne prospieva ich rastu. Tieto prvky a negatívne dôsledky sú pritom manažmentu Facebooku dlhodobo známe.

Wall Street Journal poukázal na interný report z roku 2016, ktorý pre manažment vypracovala sociologička Monica Lee. V ňom upozorňovala na to, ako extrémistický obsah živo prosperuje napríklad na tretine veľkých nemeckých politických Facebook skupín. Vypichla pri tom to, že sú plné rasistického, konšpiračného a proruského obsahu, pričom celá veľká skupina je disproporčne formovaná skupinou hyperaktívnych používateľov, ktorú ostatní sledujú a jej obsah konzumujú. V prezentácii pritom manažment upozorňovala, že zavedené algoritmy siete sa priamo podieľajú na ich masívnom raste v posledných rokoch, pričom 64 % členov týchto skupín do nich vošlo na základe odporúčacích algoritmov UI („Skupiny, do ktorých by sa mal pridať“).

Na priame otázky Wall Street Journal, ako sa zmenila politika firmy a ich algoritmov po tomto reporte, odmietol Facebook a takisto Monica Lee, ktorá vo firme stále pracuje, priamo odpovedať. Z výpovedí ostatných zamestnancov každopádne vieme, že tieto problémy sú dlhodobé a vždy boli globálne, takže sa vonkoncom netýkali len Nemecka, ktorému sa interný report venoval.

V minuloročnej prezentácii na medzinárodnej bezpečnostnej konferencii sa Mark Zuckerberg vyjadril, že Facebook sa dnes snaží neodporúčať skupiny, ktoré porušujú pravidlá komunity. Podľa hovorcov spoločnosti sa firma od roku 2016 mnoho naučila a rozhodne nie je už rovnaká. Exaktné dáta ktoré by to potvrdzovali však chýbajú, pričom ako príklad môže slúžiť útok na americký Kapitol v januári tohto roku, pri ktorom šírenie dezinformácií na Facebooku zohralo nemalú rolu.

Samotný Zuckerberg a hovorcovia Facebooku v súčasnosti opakovane vyzdvihujú, že spoločnosť sa tieto slabiny pokúša riešiť. „Vybudovali sme robustný tím na zachovanie integrity, posilňujeme a sprísňujeme naše pravidlá v súvislosti so škodlivým obsahom a podporujeme výskum toho, ako naša platforma vplýva na spoločnosť. Stále sa zlepšujeme.“ V posledných dvoch rokoch firma výrazne poukazuje na svoju špeciálnu skupinu „Responsible AI“, teda v preklade „zodpovedná umelá inteligencia“, ktorej účelom je odhaľovať prípadné nedostatky algoritmov a riešiť ich.

V rámci týchto snách vytvoril vývojový tím Joaquina Quiñonero Candelu nový nástroj, nazvaný „Fairness Flow“, čo sa dá preložiť ako prúd férovosti. Funguje ako doplnok FBLearner Flow, ktorý vývojári Facebooku používajú na tréning a rýchle vyvíjanie modelov UI. Doplnkový „Fairness Flow“ môžu (ale nemusia) použiť na overenie vytvoreného modelu v súvislosti s rozdielnymi etnickými skupinami či pohlaviami. Ide napríklad o to, či algoritmus detekcie tváre dobre rozpoznáva ľudí všetkých rás a pohlaví a podobne.

Problémom je, že tento prístup sa venuje predovšetkým rasovej diskriminácii. Typicky napríklad v tom zmysle, aby bolo zabránené tomu, že napríklad osoby s jednou farbou pokožky by videli iné reklamné ponuky na pracovné príležitosti ako osoby s inou a nedochádzalo tak vyčleňovaniu a negatívnym efektom v tejto súvislosti. Tieto snahy sú síce dôležité a jednoznačne chcené, avšak je treba si povšimnúť veľmi dôležitú a očividnú vec – tieto snahy sa týkajú výhradne problematiky, ktorá nijako nevplýva na rast Facebooku.

Aj keď vedenie Facebooku tieto snahy opakovane prezentuje ako svoju preukázateľnú snahu bojovať s negatívnymi vplyvmi svojich zoraďovacích algoritmov, experti z oboru UI si rýchlo všimli, že sa nijako netýkajú problémov, ktoré boli v posledných rokoch najakútnejšie, predovšetkým v súvislosti s polarizáciou spoločnosti, radikalizáciou, podnecovaním hnevu a nenávisti. Tie všetky vyplývajú z fungovania algoritmov, ktoré si slepo všímajú len maximalizáciu zapojenia a aktivity.

Všetko, čo Facebook v posledných dvoch dekádach robil alebo naopak úmyselne nerobil, sa odvíjalo od veľmi jednoduchého pravidla. Konkrétne od Zuckerbergovej neutíchajúcej mantry o nekonečnom raste firmy. Facebook musí používať stále viac ľudí. Musí generovať stále viac peňazí. Nesmie sa stať nerelevantným a strácať dych. Niet cesty späť.

A plán, ako to dosiahnuť, sa celý čas nemení. Hon na stále väčšie zapojenie, na stále väčšiu aktivitu, na stále dlhší čas, ktorý používatelia na sieti trávia.

Z úst hovorcov či vrcholových manažérov firmy neustále počujeme, že „Facebook neprofituje na nenávisti“. Že po ničom takom netúžia a cielene to nerobia. Je to, ako keby sa tabakové spoločnosti vo svojom najväčšom rozkvete hájili, že neprofitujú zo smrti a pľúcnych chorôb. Že v ich záujme je, aby ich zákazníci žili čo najdlhšie a boli zdraví.

To je úplná pravda, ale celkom určite viete, že takýto argument by ignoroval fakt, že princíp ich produktu k tomu nevyhnutne vedie. Poľovanie sociálnych sietí na závislosť, hnev a chorobné veľké zapojenie, nás priviedlo k polarizácii spoločnosti a k extrémnemu zvýšeniu radikalizácie. To nie sú akési nechcené vedľajšie efekty, ktoré na sociálnych sieťach nevyhnutne musia byť prítomné. Nie je nejaká nešťastná zhoda okolností. Tieto mechanizmy boli cielene cibrené, hľadané a chcené, pretože prinášajú rast firmy.

A my všetci budeme tými, ktorí za to „zaplatia“.

Tento článok vyšiel aj v tlačenom vydaní TOUCHIT, č. 7-8/2021, preto sa niektoré skutočnosti môžu odlišovať oproti aktuálnemu dátumu publikovania.

Podobné články

Messenger.com onedlho končí. Čo to pre vás znamená?

Ako nájsť Reels na Instagrame? Pozrite si ho v histórii

WhatsApp pripravuje predplatné, zbaví vás reklám v aplikácii

Používate Threads? Od budúceho týždňa vás čaká veľká zmena