Koľko RAM potrebujem na umelú inteligenciu v počítači?

AI môžete prevádzkovať na počítači u seba doma ale rýchlosť bude závisieť o kapacity RAM grafickej karty alebo RAM všeobecne.

Ide najmä o LLM modely, grafické modely vyžadujú aj silnú grafickú kartu s tzv. tensor jadrami. Nedostatočná kapacita VRAM bude hlavným argumentom, prečo AI nie je dostatočne rýchla. Výrobcovia pripravujú špecializované CPU s AI funkciami, ale sú prispôsobené na nižšiu kapacitu RAM. Ako je to možné?

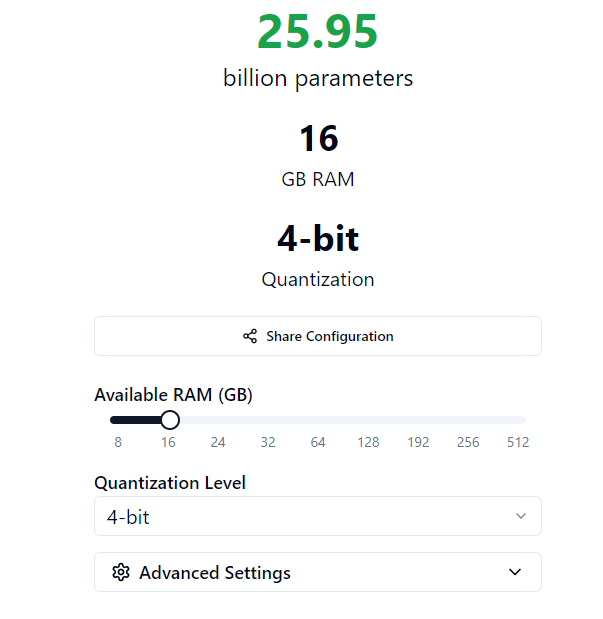

LLM RAM Calculator vám pomôže získať predstavu o tom, aké jazykové modely budú bežať na vašom počítači. Na základe operačnej pamäte si vypočítate veľkosť jazykového modelu. Napríklad model Llama od Meta je v niekoľkých verziách.

Funguje ako 1B a 3B (miliardy) model na koncových zariadeniach, typicky smartfónoch a tabletoch. Potom je tu model, ktorý má 11B a 90B parametrov. Na toto už potrebujete silnú zostavu. Voľne dostupný je aj Mistral s niekoľkými verziami podľa množstva parametrov (a žravosti RAM). Na jazykový model Llama 2 bude stačiť 16 GB RAM v počítači.

Okrem toho sa v súvislosti s jazykovými modelmi používa tzv. kvantizácia na zníženie výpočtovej a pamäťovej náročnosti. Bežne sa parametre (váhy) ukladajú ako 32-bitové čísla. Keď ich rozdelíme na menšie, napríklad 8-bitové (int8) získame úsporu v pamäti. Zároveň ale aj miernu odchýlku od presnosti. To je údaj v kalkulačke, ktorý vidíte na poslednom riadku.

Zdroj: Ray Fernando

Prečítajte si aj:

Podobné články

ChatGPT a rok 2025: Prezradí, o čom ste sa rozprávali

Copilot AI Agent vytvorí prezentácie aj dokumenty zadarmo

OPPO Reno15: Tieto smartfóny očakávame, prídu aj do Európy

TOP 10 najobľúbenejších filmov na internete – 51. týždeň

Smartfóny v roku 2026: viac odolné a vylepšenie fotografie cez AI

TCL na CES 2026 ukáže budúcnosť zobrazovacích technológií a AI ekosystémov